Un fichier robots.txt est un fichier texte utilisé par les administrateurs de sites web pour donner des instructions aux robots d’exploration (également appelés « bots » ou « spiders ») sur la façon dont ils doivent interagir avec le site. Ces robots sont généralement utilisés par les moteurs de recherche comme Google, Bing, et Yahoo pour indexer les pages web. Le fichier robots.txt est une partie intégrante du protocole d’exclusion des robots (REP), qui permet aux webmasters de contrôler l’accès des robots d’exploration à leur site.

Contenu et Fonctionnement du Fichier robots.txt

Le fichier robots.txt est placé dans le répertoire racine du site web (par exemple, https://www.exemple.com/robots.txt). Il contient des directives qui spécifient les parties du site que les robots peuvent ou ne peuvent pas explorer. Voici les principaux éléments d’un fichier robots.txt :

- User-agent :

- Spécifie à quel robot l’instruction s’applique. Chaque moteur de recherche a son propre user-agent (par exemple,

Googlebotpour Google). - Exemple :

User-agent: Googlebot

- Spécifie à quel robot l’instruction s’applique. Chaque moteur de recherche a son propre user-agent (par exemple,

- Disallow :

- Indique les URL que le robot ne doit pas explorer.

- Exemple :

Disallow: /dossier-prive/

- Allow :

- Utilisé pour autoriser l’exploration d’une sous-partie d’un répertoire qui a été disallow.

- Exemple :

Allow: /dossier-prive/page-publique.html

- Sitemap :

- Indique l’emplacement du fichier sitemap XML qui fournit une liste des pages du site que le webmaster souhaite faire indexer par les moteurs de recherche.

- Exemple :

Sitemap: https://www.exemple.com/sitemap.xml

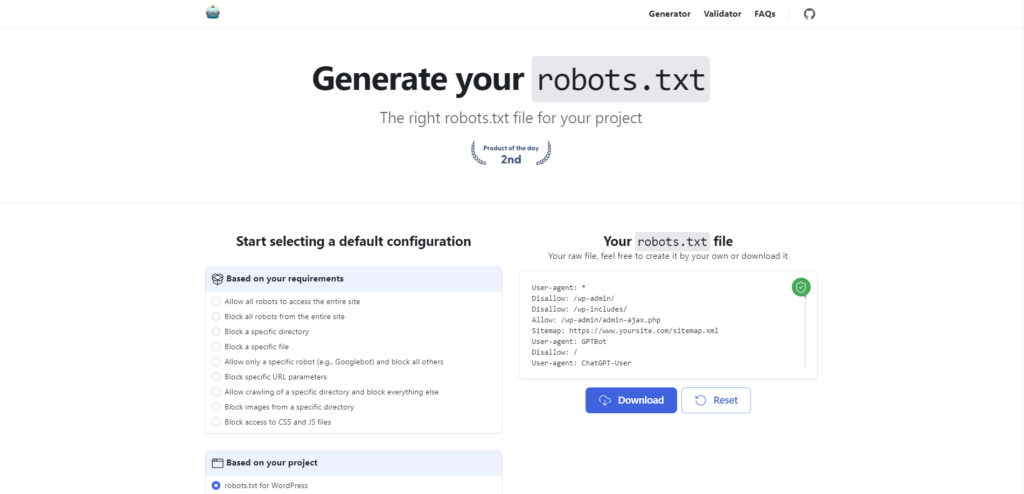

Un générateur gratuit en ligne pour votre fichier robots.txt

Robots.txt Generator est un outil en ligne gratuit et open source dont l’objectif est de vous faciliter la création de votre fichier robots.txt.

De nombreuses options sont proposées et peuvent être affinées. Parmi ces options, vous pouvez opter pour :

- Configurations de base : autoriser tous les robots, bloquer tous les robots, bloquer un répertoire ou un fichier spécifique, autoriser uniquement un robot particulier (ex : Googlebot), et bien plus encore.

- Configurations spécifiques à certains projets : générer un fichier robots.txt optimisé pour WordPress, Shopify, Magento, Drupal, Joomla, PrestaShop, etc.

- Gestion des robots d’IA : autoriser ou bloquer l’accès aux robots d’IA comme ChatGPT, Claude, Gemini (anciennement Bard), YouBot, et bien d’autres.

- Directive Sitemap : indiquer l’URL de votre fichier Sitemap pour aider les moteurs de recherche à explorer votre site.

Importance du Fichier robots.txt

- Gestion de la Charge du Serveur :

- Empêche les robots d’explorer des parties du site qui ne sont pas nécessaires, réduisant ainsi la charge sur le serveur.

- Confidentialité :

- Permet d’exclure les pages sensibles ou non publiques des résultats de recherche.

- Optimisation du Budget d’Exploration :

- Aide à orienter les robots vers les pages importantes du site, optimisant ainsi l’utilisation du budget d’exploration alloué par les moteurs de recherche.

- Prévention des Contenus Duplicates :

- Empêche l’indexation des pages qui pourraient causer des problèmes de contenus dupliqués.

Le fichier robots.txt est un outil puissant pour les webmasters, permettant de contrôler et d’optimiser l’exploration de leur site web par les robots d’exploration des moteurs de recherche. En l’utilisant correctement, il est possible de protéger les zones sensibles du site, d’améliorer l’efficacité de l’indexation, et de gérer la charge du serveur. Cependant, il est important de comprendre ses limites et de ne pas l’utiliser comme un moyen de sécurité absolue.

* * Cette case à cocher est obligatoire

*J'accepte